Nvidia เพิ่งประกาศเปิดตัวโมเดลภาษาโอเพนซอร์สขนาดใหญ่ (LLM) ที่คาดว่าจะมีประสิทธิภาพทัดเทียมกับโมเดลกรรมสิทธิ์ชั้นนำจาก OpenAI, Anthropic, Meta และ Google

รุ่นใหม่นี้เรียกว่า NVLM-D-72B ซึ่งมีพารามิเตอร์ 72 พันล้านพารามิเตอร์ และเป็นส่วนหนึ่งของตระกูลโมเดลภาษา NVLM 1.0 ขนาดใหญ่ที่ Nvidia เปิดตัวเมื่อเร็วๆ นี้ NVLM 1.0 เป็นกลุ่มของโมเดลภาษามัลติโหมดขนาดใหญ่ที่มีขอบเขตจำกัด ซึ่งให้ผลลัพธ์ที่ล้ำสมัยในงานภาษาภาพ โดยแข่งขันกับโมเดลกรรมสิทธิ์ชั้นนำ (เช่น GPT-4o) เช่นเดียวกับโมเดลการเข้าถึงแบบเปิด

รายงานระบุว่าตระกูลใหม่ของโมเดลภาษาขนาดใหญ่มี “ความสามารถแบบหลายโหมดระดับอุตสาหกรรม” โดยมีประสิทธิภาพที่เหนือกว่าในงานภาพและภาษาที่หลากหลาย นอกเหนือจากการปรับปรุงการตอบสนองตามข้อความอย่างมีนัยสำคัญ “เพื่อให้บรรลุเป้าหมายดังกล่าว เราจึงสร้างและบูรณาการชุดข้อมูลที่เป็นข้อความคุณภาพสูงเข้ากับกระบวนการฝึกอบรมแบบมัลติโหมด พร้อมด้วยข้อมูลทางคณิตศาสตร์และการใช้เหตุผลแบบมัลติโหมดจำนวนมาก ส่งผลให้ความสามารถทางคณิตศาสตร์และการเข้ารหัสได้รับการปรับปรุงดีขึ้นในหลายโหมด” นักวิจัยของ Nvidia อธิบายในแถลงการณ์

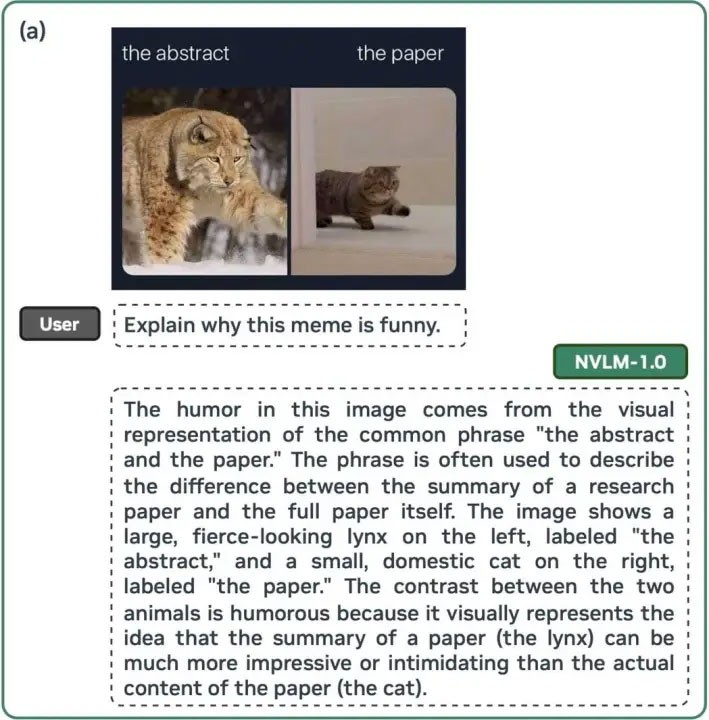

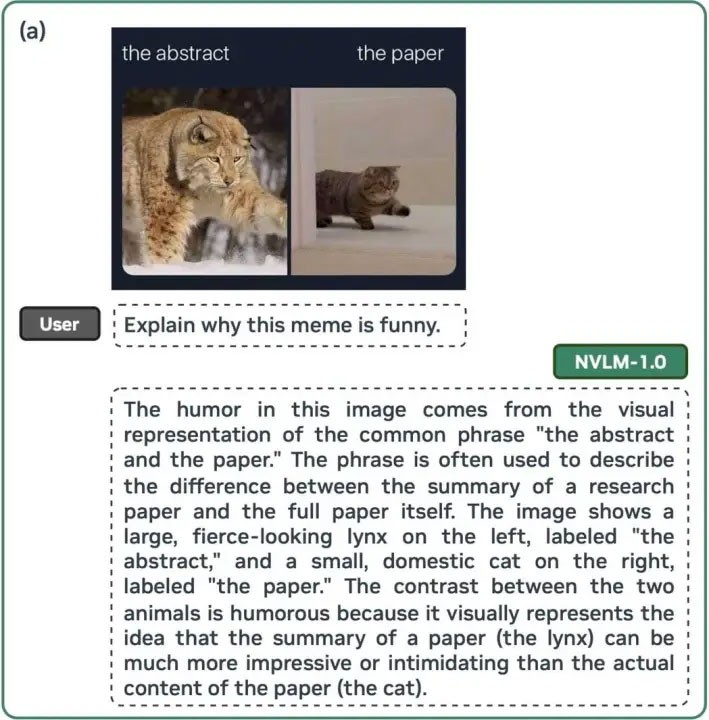

ผลลัพธ์ที่ได้คือ LLM ประสิทธิภาพสูงที่สามารถทำภารกิจง่ายๆ เช่น การอธิบายว่าทำไมมีมถึงตลก รวมไปถึงสมการทางคณิตศาสตร์ที่ซับซ้อนแบบทีละขั้นตอน นอกจากนี้ Nvidia ยังสามารถเพิ่มความแม่นยำของข้อความเพียงอย่างเดียวของโมเดลได้โดยเฉลี่ย 4.3 จุดเหนือเกณฑ์มาตรฐานอุตสาหกรรม โดยอาศัยรูปแบบการฝึกแบบหลายโหมด

Nvidia ดูเหมือนจริงจังกับการทำให้แน่ใจว่าโมเดลนี้ตรงตามคำจำกัดความล่าสุดของ Open Source Initiative ว่าเป็น "โอเพนซอร์ส" โดยไม่เพียงแต่เปิดเผยน้ำหนักในการฝึกเพื่อให้ชุมชนตรวจสอบเท่านั้น แต่ยังสัญญาที่จะเผยแพร่โค้ดต้นฉบับของโมเดลนี้ในอนาคตอันใกล้นี้ด้วย ถือเป็นการเปลี่ยนแปลงที่สำคัญจากแนวทางของคู่แข่ง เช่น OpenAI และ Google ที่ไม่ยอมเปิดเผยรายละเอียดเกี่ยวกับน้ำหนักและโค้ดต้นฉบับของโมเดล LLM ให้เป็นส่วนตัว ในการดำเนินการดังกล่าว Nvidia ได้วางตำแหน่ง NVLM ไม่จำเป็นต้องเป็นคู่แข่งโดยตรงกับ ChatGPT-4o และ Gemini 1.5 Pro แต่เป็นแพลตฟอร์มสำหรับนักพัฒนาบุคคลที่สามเพื่อสร้างแชทบอทและแอปพลิเคชัน AI ของตัวเอง