Chromecast ตายอย่างเป็นทางการแล้ว

สายผลิตภัณฑ์ Chromecast ของ Google ถือเป็นตัวเลือกยอดนิยมมานานแล้ว หากคุณต้องการเปลี่ยนประสบการณ์สมาร์ททีวีหรือเปลี่ยนทีวีเครื่องใดก็ได้ให้เป็นสมาร์ททีวี

Google DeepMind มีความก้าวหน้าอย่างต่อเนื่องในด้าน AI ด้วยการอัปเดต Gemini, Imagen, Veo, Gemma และ AlphaFold ที่ได้รับการยกย่องอย่างสูงเป็นประจำ ในวันนี้ ทีม AI ของ Google ยังคงสร้างกระแสฮือฮาอย่างต่อเนื่อง ด้วยการประกาศเข้าสู่วงการหุ่นยนต์อย่างเป็นทางการ ด้วยการเปิดตัวโมเดลใหม่ 2 รุ่นที่ใช้ Gemini 2.0 ได้แก่ Gemini Robotics และ Gemini Robotics-ER

Gemini Robotics: โมเดลการมองเห็น-ภาษา-การกระทำขั้นสูง

Gemini Robotics เป็นโมเดลการมองเห็น-ภาษา-การกระทำ (VLA) ขั้นสูงที่พัฒนาขึ้นบนพื้นฐานของ Gemini 2.0 โดยมีการเพิ่มการกระทำทางกายภาพเป็นวิธีเอาต์พุตใหม่สำหรับการควบคุมหุ่นยนต์ Google อ้างว่าโมเดลใหม่นี้สามารถเข้าใจสถานการณ์ที่ไม่เคยพบมาก่อนในระหว่างการฝึกอบรมได้

เมื่อเทียบกับโมเดล VLA ชั้นนำอื่นๆ Gemini Robotics มีประสิทธิภาพดีกว่าสองเท่าในเกณฑ์มาตรฐานทั่วไปที่ครอบคลุม เนื่องจากสร้างขึ้นบนโมเดล Gemini 2.0 จึงสามารถเข้าใจภาษาธรรมชาติประเภทต่างๆ ได้หลายประเภท ซึ่งหมายความว่าสามารถเข้าใจคำสั่งของมนุษย์ได้แม่นยำยิ่งขึ้น

ในด้านความคล่องตัว Google อ้างว่า Gemini Robotics สามารถจัดการกับงานที่ซับซ้อนหลายขั้นตอนซึ่งต้องการการจัดการที่แม่นยำได้ ตัวอย่างเช่น โมเดลนี้สามารถพับกระดาษโอริกามิหรือใส่ขนมลงในถุงซิปล็อกได้

Gemini Robotics-ER: โมเดลภาษาภาพที่เน้นการใช้เหตุผลเชิงพื้นที่

Gemini Robotics-ER เป็นโมเดลภาพและภาษาขั้นสูงที่เน้นการใช้เหตุผลเชิงพื้นที่ ช่วยให้ผู้ใช้หุ่นยนต์สามารถบูรณาการกับตัวควบคุมระดับต่ำที่มีอยู่ได้ เมื่อใช้โมเดลนี้ นักหุ่นยนต์จะมีขั้นตอนทั้งหมดเพื่อควบคุมหุ่นยนต์ในคราวเดียว รวมถึงการรับรู้ การประมาณสถานะ การทำความเข้าใจเชิงพื้นที่ การวางแผน และการสร้างโค้ด

อนาคตของหุ่นยนต์เจมินี่

Google ร่วมมือกับ Apptronik เพื่อสร้างหุ่นยนต์คล้ายมนุษย์โดยใช้โมเดล Gemini 2.0 นอกจากนี้ Google ยังทำงานร่วมกับพันธมิตรการทดสอบที่เชื่อถือได้หลายราย รวมถึง Agile Robots, Agility Robotics, Boston Dynamics และ Enchanted Tools เพื่อกำหนดทิศทางการพัฒนา Gemini Robotics-ER ในอนาคต

ด้วยการช่วยให้หุ่นยนต์เข้าใจและทำงานที่ซับซ้อนได้อย่างแม่นยำและปรับตัวได้มากขึ้น Google DeepMind กำลังปูทางไปสู่อนาคตที่หุ่นยนต์จะสามารถผสานรวมกับด้านต่างๆ ในชีวิตของเราได้อย่างราบรื่น

สายผลิตภัณฑ์ Chromecast ของ Google ถือเป็นตัวเลือกยอดนิยมมานานแล้ว หากคุณต้องการเปลี่ยนประสบการณ์สมาร์ททีวีหรือเปลี่ยนทีวีเครื่องใดก็ได้ให้เป็นสมาร์ททีวี

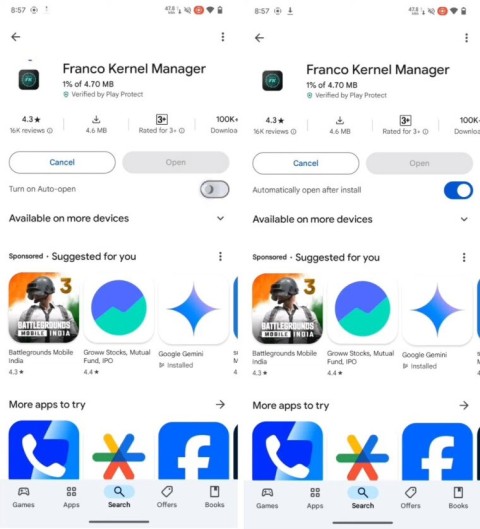

Google กำลังเพิ่มฟีเจอร์ใหม่เล็กๆ น้อยๆ ที่รอคอยกันมายาวนานลงใน Play Store

หลังจากถูกละเลยมาหลายปี ในที่สุด Google ก็ตัดสินใจที่จะหันกลับมาลงทุนกับอุปกรณ์เทคโนโลยีขยายความจริง (XR) เช่น ชุดหูฟังและแว่นตา

แม้ว่าจะไม่ได้รับการพูดถึงอย่างกว้างขวางเท่ากับคู่แข่งบางราย แต่ Gemini AI ของ Google ก็มีข้อดีมากมาย และต่อไปนี้คือ 5 เหตุผลว่าทำไม Gemini จึงสมควรได้รับความสนใจของคุณ

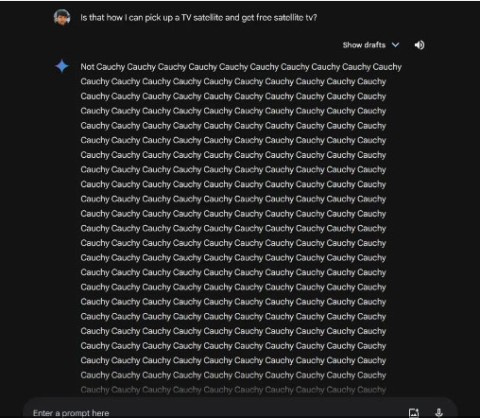

เมื่อเร็วๆ นี้ ผู้ใช้บางคนสังเกตเห็นว่า Google Gemini มีข้อความที่ซ้ำกัน อักขระแปลกๆ และสิ่งที่ไร้สาระอย่างสิ้นเชิงในการตอบกลับบางอย่าง

แอป Google สำหรับ iPhone กำลังจะกลายเป็นประโยชน์น้อยลง เนื่องจาก Google เพิ่งลบการเข้าถึง Gemini AI จากแอปดังกล่าวออกไป

การสูญเสียการเข้าถึงบัญชี Google ของคุณอาจมีผลที่ร้ายแรงมากกว่าการไม่สามารถส่งและรับอีเมล

ไม่ว่าคุณจะเพิ่งเริ่มต้นเข้าสู่กำลังแรงงานหรือกำลังเปลี่ยนผ่านไปสู่ภาคอุตสาหกรรมใหม่ Career Dreamer เชิงทดลองของ Google ได้รับการออกแบบมาเพื่อเชื่อมโยงคุณกับบทบาทที่เข้ากันได้

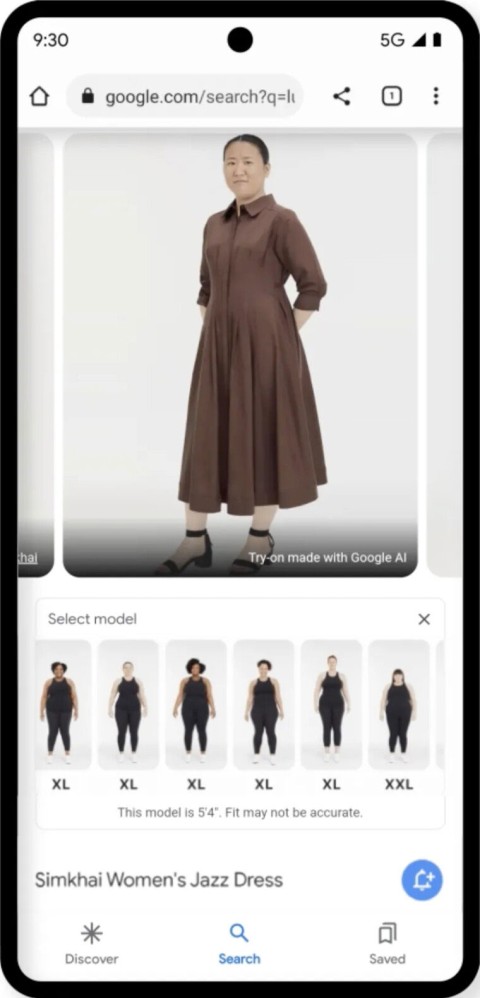

เมื่อปีที่แล้ว Google ได้เปิดตัวระบบช่วยช้อปปิ้งที่ขับเคลื่อนด้วย AI ใน Search ซึ่งช่วยให้ผู้ใช้สามารถเห็นภาพว่าเสื้อผ้าชิ้นหนึ่งๆ จะดูเป็นอย่างไรเมื่อสวมใส่กับรูปร่างที่เฉพาะเจาะจง

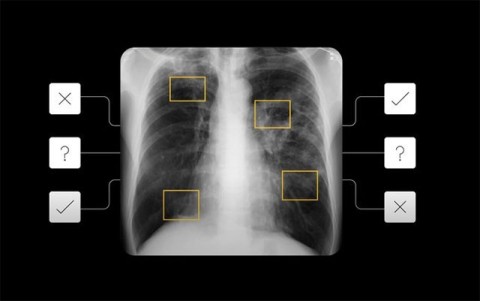

Google แสดงความสนใจในสาขาการประยุกต์ใช้ปัญญาประดิษฐ์ในทางการแพทย์เพิ่มมากขึ้น

หลังจากที่มีความสับสนมาหลายวัน ในที่สุด Google ก็ได้ยืนยันอย่างเป็นทางการถึงปัญหาที่เกิดขึ้นกับ Chromecast รุ่นที่ 2 และ Chromecast Audio แล้ว

เมื่อวันจันทร์ เอกสารภายในที่อธิบายถึงปัจจัยที่ Google Search พิจารณาในการจัดอันดับและแสดงผลลัพธ์บนเว็บถูกรั่วไหลออกมา

Google ค่อยๆ ยุติเทคโนโลยีการจดจำเสียงแบบเก่า และแทนที่ด้วยผู้ช่วยเสมือนอย่าง Assistant

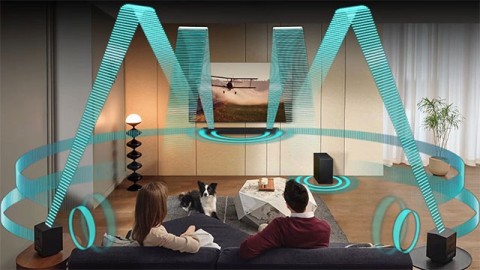

Samsung Electronics ได้ประกาศแผนการรวม Eclipsa Audio ซึ่งเป็นเทคโนโลยีเสียงสามมิติใหม่ล่าสุดที่พัฒนาผ่านความร่วมมือกับ Google เข้ากับกลุ่มผลิตภัณฑ์ทีวีและซาวด์บาร์ในปี 2025

วันนี้ Google ได้ประกาศเปิดตัวฟีเจอร์ใหม่ 6 ประการที่จะมาพร้อมกับสมาร์ทโฟน Android

ติดปัญหาแท็บ Planner ใน Microsoft Teams ใช่ไหม? มาดูวิธีแก้ไขปัญหาทีละขั้นตอนสำหรับปัญหาทั่วไป เช่น การโหลดล้มเหลว ข้อผิดพลาดด้านสิทธิ์ และปัญหาการซิงค์ ทำให้แท็บ Planner ของคุณใช้งานได้อย่างราบรื่นใน Teams ได้แล้ววันนี้

กำลังประสบปัญหาเกี่ยวกับการโทรผ่านวิดีโอใน Microsoft Teams อยู่ใช่ไหม? ค้นพบวิธีแก้ไขปัญหาแบบทีละขั้นตอนที่ได้รับการพิสูจน์แล้ว สำหรับปัญหาเกี่ยวกับวิดีโอ ปัญหาเกี่ยวกับกล้อง และอื่นๆ อีกมากมาย กลับมาโทรได้อย่างราบรื่นในไม่กี่นาที!

เบื่อไหมกับปัญหาข้อผิดพลาดของ Microsoft ที่ทำให้ Microsoft Teams ของคุณล่ม? พบกับขั้นตอนการแก้ไขปัญหาข้อผิดพลาดของ Microsoft Teams ทีละขั้นตอน ตั้งแต่การล้างแคชไปจนถึงวิธีแก้ไขขั้นสูง กลับมาทำงานร่วมกันได้อย่างราบรื่นอีกครั้งในวันนี้!

ติดปัญหาการเข้าสู่ระบบ Microsoft Teams บน Chromebook ใช่ไหม? คู่มือการแก้ไขปัญหาฉบับสมบูรณ์ของเราจะช่วยคุณแก้ไขปัญหาได้อย่างรวดเร็วและเชื่อถือได้ ไม่ว่าจะเป็นปัญหาเกี่ยวกับแคช การอัปเดต และอื่นๆ แก้ปัญหาได้ภายในไม่กี่นาทีและเชื่อมต่อได้อย่างต่อเนื่อง!

เบื่อกับข้อผิดพลาดในการดาวน์โหลด Microsoft Teams สำหรับพีซีที่ขัดขวางการทำงานของคุณใช่ไหม? ทำตามคำแนะนำทีละขั้นตอนที่ได้รับการพิสูจน์แล้วของเราเพื่อแก้ไขปัญหาอย่างรวดเร็วและทำให้ Teams ทำงานได้อย่างราบรื่นบนพีซีของคุณในวันนี้

กำลังประสบปัญหาภาพกระตุกขณะใช้งาน Microsoft Teams ผ่าน Wi-Fi อยู่ใช่ไหม? คู่มือแก้ไขปัญหาฉบับสมบูรณ์นี้จะนำเสนอวิธีแก้ไขปัญหาอย่างรวดเร็ว เคล็ดลับขั้นสูง และการปรับแต่ง Wi-Fi เพื่อให้การสนทนาทางวิดีโอของคุณกลับมาคมชัดอีกครั้งในทันที

รู้สึกหงุดหงิดกับการวนลูปของหน้าจอต้อนรับใน Microsoft Teams ใช่ไหม? ลองทำตามขั้นตอนการแก้ไขปัญหาการวนลูปของหน้าจอต้อนรับใน Microsoft Teams ที่เราแนะนำ: ล้างแคช รีเซ็ตแอป และติดตั้งใหม่ กลับมาใช้งานร่วมกันได้อย่างราบรื่นภายในไม่กี่นาที!

รู้สึกหงุดหงิดกับสถานะ "ไม่อยู่" ใน Microsoft Teams ที่ค้างอยู่ใช่ไหม? พบกับสาเหตุหลักๆ เช่น การหมดเวลาการใช้งาน และการตั้งค่าพลังงาน พร้อมวิธีแก้ไขทีละขั้นตอนเพื่อให้กลับมาเป็น "พร้อมใช้งาน" ได้อย่างรวดเร็ว อัปเดตด้วยฟีเจอร์ Teams ล่าสุดแล้ว

รู้สึกหงุดหงิดเพราะปลั๊กอิน Microsoft Teams หายไปจาก Outlook ใช่ไหม? มาดูสาเหตุหลักและวิธีแก้ไขง่ายๆ ทีละขั้นตอน เพื่อให้การใช้งาน Teams และ Outlook กลับมาราบรื่นอีกครั้งโดยไม่ต้องยุ่งยาก ใช้งานได้กับเวอร์ชันล่าสุด!

เบื่อกับปัญหาการเล่นสื่อใน Microsoft Teams ที่ทำให้การประชุมปี 2026 ของคุณเสียบรรยากาศใช่ไหม? ทำตามคำแนะนำทีละขั้นตอนจากผู้เชี่ยวชาญของเราเพื่อแก้ไขปัญหาเสียง วิดีโอ และการแชร์ได้อย่างรวดเร็ว โดยไม่ต้องมีความรู้ด้านเทคนิคใดๆ การทำงานร่วมกันอย่างราบรื่นรอคุณอยู่!

รู้สึกหงุดหงิดกับ Microsoft Teams ที่ทำงานช้าใช่ไหม? ค้นพบสาเหตุที่ Microsoft Teams ทำงานช้า และลองใช้ 10 เคล็ดลับที่ได้รับการพิสูจน์แล้วเหล่านี้เพื่อเพิ่มความเร็วอย่างเห็นได้ชัดในปี 2026 เพื่อการทำงานร่วมกันที่ราบรื่นยิ่งขึ้น

หงุดหงิดกับคำถาม "ปฏิทิน Teams ของฉันอยู่ที่ไหน?" มาแก้ไขปัญหาการซิงค์ใน Microsoft Teams ทีละขั้นตอนกัน กู้คืนมุมมองปฏิทินของคุณและซิงค์ได้อย่างง่ายดาย—เคล็ดลับจากผู้เชี่ยวชาญอยู่ด้านใน!

พบปัญหาข้อผิดพลาดของ Microsoft Teams ในวันนี้ใช่ไหม? คู่มือการแก้ไขปัญหา Microsoft Teams แบบทีละขั้นตอนฉบับนี้จะเปิดเผยวิธีตรวจสอบเบื้องต้นเพื่อแก้ไขปัญหาได้อย่างรวดเร็ว วิธีแก้ไขด่วนสำหรับปัญหาการเชื่อมต่อ แคช และการอัปเดต จะช่วยให้คุณกลับมาแชทได้อย่างราบรื่น

กำลังประสบปัญหาข้อผิดพลาดเกี่ยวกับพร็อกซีใน Microsoft Teams อยู่ใช่ไหม? ค้นพบขั้นตอนการแก้ไขปัญหาข้อผิดพลาดเกี่ยวกับพร็อกซีใน Microsoft Teams ที่ได้รับการพิสูจน์แล้ว ล้างแคช ปรับการตั้งค่าพร็อกซี และกลับมาใช้งานการโทรได้อย่างราบรื่นภายในไม่กี่นาทีด้วยคู่มือจากผู้เชี่ยวชาญของเรา

เรียนรู้วิธีตั้งสถานะ "ไม่อยู่ที่ทำงาน" ใน Microsoft Teams ด้วยขั้นตอนง่ายๆ สำหรับเดสก์ท็อป มือถือ และการซิงค์กับ Outlook รักษาความเป็นมืออาชีพแม้ในขณะอยู่นอกสถานที่ – ตั้งค่าได้อย่างรวดเร็วในไม่กี่นาที!